Любой процесс сопоставления меры с измеряемым объектом никогда не может быть идеальным в том смысле, что процедура, повторенная несколько раз, обязательно даст различные результаты. Поэтому, с одной стороны, невозможно в процессе измерения сразу получить истинное значение измеряемой величины, и, с другой стороны, результаты любых двух повторных измерений будут отличаться друг от друга. Причины расхождений могут быть самыми разнообразными, но условно их можно разделить на две группы.

Первая группа расхождений результатов измерения - возможные изменения свойств самого измеряемого объекта. Например, при измерении длины размер предмета может измениться под действием температуры - хорошо известное свойство тел расширяться или уменьшаться при изменении температуры. В других видах измерения встречается та же самая ситуация, т. е. под влиянием температуры может измениться давление в замкнутом объеме газа, может измениться сопротивление проводника, коэффициент отражения поверхности и т. д.

Вторая группа расхождений - несовершенство средств измерений, несовершенство методики измерений или недостаточная квалификация и тщательность работы оператора. Этот тезис достаточно очевиден, тем не менее, оценивая погрешности измерений, нередко забывают о том, что эти факторы нужно учитывать в комплексе. Измерительная практика показывает, что грубым прибором можно получить достаточно близкие к истинным значениям результаты за счет совершенствования методики или искусства оператора. И наоборот, самый точный прибор даст ошибочные результаты, если в процессе измерения не соблюдаются предпосылки реализации метода.

В качестве примера можно привести взвешивание на безмене -двухплечевом рычаге с грузом на одном конце и с измеряемой массой на другом конце. Это средство измерения само по себе весьма примитивно, но если его тщательно отградуировать и выполнить многоразовые измерения желаемой величины, то результат может оказаться достаточно точным. Примером противоположного плана является измерения состава какого-либо вещества. Если мы захотим измерить содержание хлора в воде или двуокиси серы в дымовом газе и не будем следовать установленной опытом методике, то самый точный анализатор даст неверный результат, т. к. состав пробы за время транспортировки может сильно измениться.

Учитывая факторы обеих групп, невозможно получить абсолютно точно значение измеряемой физической величины. Во всех реальных ситуациях этого и ненужно. В измерительной технике существует критерий достаточности, то есть расхождение между результатом измерения и истинным значением всегда определяется конкретной задачей. Нет смысла, например, измерять климатические параметры в помещении с точностью лучше 1%. С другой стороны, при воспроизведении единиц длины такая точность явно не обеспечит необходимых требований.

Нужно в такого рода оценках учитывать более высокую стоимость более точного прибора, большую громоздкость, более высокое энергопотребление, меньшую экспрессность измерений и т.д. и т.п. И, естественно, нужно всегда помнить, что измерения сами по себе никогда не проводят ради самих измерений. Они всегда имеют подчиненный характер, т. е. выполняются для того чтобы затем совершить какие-либо действия. Даже если прибор фиксирует отсутствие необходимости что-либо делать, это само по себе является целью измерения. Например, с установлением температуры тела человека в 36,6°С достигнута определенная цель - никаких действий к изменению температуры принимать не надо.

Подчиненный характер измерений не умаляет их важность во всей жизнедеятельности человека. Достаточно сказать, что великие открытия современности, такие как термоядерные реакции или лазеры, в основе своей имели тщательные измерения свойств атомов и характеристик их взаимодействия. В технике деятельность вообще немыслима без измерений.

Разброс результатов однократных измерений одной и той же величины, связанных либо с изменениями свойств измеряемого объекта, либо с неидеальностью процедуры измерения, заставляет относиться к получению каждого конкретного результата как к процессу вероятностному. Соответственно, к описанию и расчету погрешностей становится применима теория вероятности, а статистика становится неотъемлемым элементом процедуры оценки точности измерений при оценке погрешностей.

Рассматривая последовательно виды погрешностей и способы их минимизации, повторим определение погрешности.

«Погрешность измерения есть разница между результатом измерения Х и действительным значением этой величины, под которым подразумевается ее значение, найденное экспериментально и настолько приближающееся к истинному Q, что для данной цели оно может быть использовано вместо него», т. е.

![]() (3.1)

(3.1)

Погрешности измерения, связанные с непостоянством размера измеряемого объекта и с несовершенством средств измерения, можно объединить в две группы.

1. Погрешности, связанные с факторами, которые изменяются при повторных измерениях хаотически, носят нерегулярный характер и их трудно предвидеть. Такие погрешности называются случайными. Иногда подобные изменения могут проявиться очень сильно, например при резком однократном изменении напряжения питания прибора. В этом случае погрешность значительно превышает границы, определяемые ходом процесса измерений в целом и ее называют грубой погрешностью или промахом.

2. Погрешности, определяемые факторами либо постоянно искажающими результат измерения, либо постоянно изменяющимися в процессе измерения называются систематическими погрешностями. Эти погрешности непросто определить, если их значение меньше или сопоставимо со случайными погрешностями.

Для выявления и учета систематических погрешностей существует определенный набор приемов и методов, которые будут рассмотрены в специальном разделе.

Обозначим случайные погрешности как σ, систематические как Θ. Суммарную погрешность Δ можно представить как

![]() (3.2)

(3.2)

Для получения результатов, минимально отличающихся от истинных значений величины, проводят многократные наблюдения за измеряемой величиной и затем проводят математическую обработку массива данных. В большинстве случаев проводят анализ результатов путем построения графика зависимости погрешности Δ от номера наблюдения, выстраивая такие номера как функцию времени наблюдения, или в порядке возрастания погрешности. Рассмотрим подробнее зависимость результата измерения от времени.

В этом случае погрешность Δ является случайной функцией времени, которая отличается от классических функций математического анализа тем, что нельзя точно сказать, какое значение она примет в момент времени t. Можно указать лишь вероятность появления ее значений в том или ином временном интервале. В серии экспериментов, состоящих из ряда последовательных наблюдений, мы получаем одну реализацию этой функции (рис. 3.1).

При повторении серии измерений, мы получаем новую реализацию, отличающуюся от первой.

Реализации отличаются из-за влияния факторов появления случайной погрешности, а факторы, определяющие систематическую погрешность, одинаково проявляются для каждого момента времени t, для всех реализации. Погрешность измерений, соответствующая каждому моменту времени ti , называется сечением случайной функции Δ(t). В каждом сечении можно найти среднее значение, одинаковое для всех реализации. Очевидно, что эта составляющая и определит систематическую погрешность Θ. Если через значения Θ для всех моментов времени провести плавную кривую, то она будет характеризовать временную тенденцию изменения погрешности.

Отклонения значений конкретных реализации от среднего значения для момента времени t дадут значения случайной погрешности σi . Эти отклонения оказываются разными для разных реализации. Последние являются уже представителями случайных величин, т. е. объектов изучения теории вероятности. Таким образом, имеет место равенство: Δ = σ + Θ.

Здесь индекс i означает принадлежность к измерениям в i момент времени, а индекс j - принадлежность k j реализации.

Вернемся теперь к основным категориям и понятиям теории погрешностей.

Точность измерений - понятие, характеризующее качество измерений. Чем выше точность, тем меньше и систематическая и случайная погрешность. Иногда класс точности измерительного прибора выражают как погрешность, отнесенную к концу шкалы, т. е.

![]() (3.3)

(3.3)

где Х - абсолютное значение измеряемой величины, отнесенное к концу шкалы.

Правильность измерений характеризует либо отсутствие, либо малость систематической погрешности, т. е. случай, когда

![]() (3.4)

(3.4)

Воспроизводимость измерений характеризует малость случайной погрешности при повторных измерениях одной и той же величины в одинаковых условиях одним и тем же методом, т. е.

![]() (3.5)

(3.5)

Сходимость измерений характеризует близость друг к другу результатов измерений, выполненных в различных условиях, различными методами, различным и экземплярам и однотипных приборов, на различных типах приборов.

Достоверность результата измерений определяется с использованием теории вероятности и характеризует вероятность показания результата однократного измерения в наперед заданный интервал отклонений результата от истинного или от действительного значения измеряемой величины. Поскольку оценка вероятности дается не с безусловной 100% достоверностью, эта категория характеризует степень доверия к результатам измерения.

Грамотное использование категорий теории погрешности дает возможность для каждого конкретного случая выбрать средства и методы измерения, обеспечивающие получение результата, погрешности которого не превышают заданных границ с заданной вероятностью.

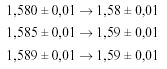

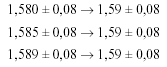

Определение случайной, систематической и общей погрешности дают возможность составить представление о том, какие значащие цифры в конечном значении действительного значения измеряемой величины являются существенными, т. е. содержат полезную информацию о точности измерений, а какие значащие цифры в записи результата являются излишними. В большинстве случаев при записи действительного значения результата измерений ограничиваются записью одной значащей цифрой того разряда, которому соответствует погрешность измерений. Например, результат Х=1, 00781 ± 0,001 имеет смысл записывать как Х= 1,008 ± 0,001, поскольку пятая цифра после запятой вообще информации об измеренной величине не несет, а значение третьей цифры должно быть округлено до 8. При округлении пользуются правилом, что если первая из заменяемых цифр равна или больше 5, остающаяся цифра увеличивается на единицу. Если эта цифра меньше 5, то она при записи отбрасывается. Приведенный ниже пример демонстрирует правила округления результата.

а)

б)

в)

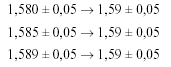

Если десятичная дробь в числовом значении результата измерения оканчивается нулями, то нули отбрасываются только до того значения, которое соответствует разряду погрешности, т. е.:

![]()

Поможем написать любую работу на аналогичную тему